La Inteligencia Artificial es un tema que genera controversia. Unos días, es vista como la solución a muchos de los problemas del mundo; otros, como la amenaza que nos llevará hacia un futuro sombrío. La realidad, como siempre, se encuentra entre ambos extremos. Los efectos de la IA serán tanto positivos como negativos, por lo que hay que hacerse algunas preguntas para determinar el uso adecuado de esta tecnología.

1. ¿Podemos utilizar la IA sin supervisión humana?

Para responder en profundidad a esta pregunta probablemente tendríamos que escribir un libro, pero no iremos tan lejos. En su lugar, podemos centrarnos en un caso de uso cada vez más popular y democratizado: los asistentes generativos de IA. A estas alturas, es probable que hayas utilizado ChatGPT o Bard o una de las diversas plataformas disponibles para cualquiera que tenga un ordenador. Pero, ¿podemos esperar siempre una respuesta perfecta cuando les realizamos una pregunta?

La respuesta corta es “no”. En muchas ocasiones, estos sistemas producen lo que llamamos alucinaciones y la IA se inventa respuestas. Las respuestas que proporcionan estas herramientas proceden del conjunto de datos de entrenamiento del algoritmo y, es posible que, en realidad, esos datos estén desfasados y no se correspondan con los conocimientos de la vida real. Un buen ejemplo es la historia de un abogado que utilizó una herramienta de IA para presentar un escrito en un tribunal. Resulta que utilizó ChatGPT para redactar todo el escrito, pero la IA decidió citar casos falsos para apoyar el escrito.

Cuando utilizamos una herramienta de IA, es probable que la supervisión humana vaya a ser necesaria siempre. Tanto si el modelo analiza los patrones meteorológicos para predecir las precipitaciones como si evalúa un modelo de negocio, puede cometer errores o incluso dar respuestas que no tienen sentido lógico. El uso adecuado de la IA, especialmente con herramientas como ChatGPT y similares, requiere de validación humana.

2. ¿Pueden los creadores de IA corregir el sesgo algorítmico a posteriori?

Esta situación resulta demasiado compleja para abordarla en este artículo, pero trataremos de proporcionar una explicación sencilla con un ejemplo. Los algoritmos de Inteligencia Artificial pueden mostrar un comportamiento discriminatorio. Por ejemplo, se ha descubierto que una IA presentaba una alta tasa de error dependiendo del sexo o la raza de las personas. También se ha observado que algunos clasificaban de forma errónea el riesgo de los reclusos, mostrando tasas desproporcionadas de reincidencia.2

¿Los ingenieros pueden ajustar su código una vez que su modelo se ha publicado? Sí, siempre es posible. Pero el proceso de verificación y supervisión debe ser una actividad constante. En cambio, lo que pueden hacer los creadores de IA es centrarse en reflejar los valores adecuados desde la concepción de sus modelos.

Los algoritmos generan resultados basados en los datos con los que se han entrenado. Si estos datos no reflejan la población a la que pretende evaluar, los sesgos inherentes se reflejarán en el modelo una vez este se active. Aunque estos modelos son sólidos, carecen de la comprensión humana básica de lo que está bien y de lo que está mal. Por esta razón, los creadores deben enfocarse desde el primer día en fomentar los valores que la IA debe tener. Si bien es cierto que luego se pueden hacer cambios, lo mejor es que los valores estén presentes desde el principio.

3. ¿Quién es responsable de las acciones de una IA?

Hace unos años, una tragedia ocurrió cuando un vehículo autónomo atropelló a un peatón. La pregunta que surgió de este incidente fue: “¿quién fue el responsable del accidente?”. ¿Era la compañía de Uber, dueña del coche? ¿O el conductor del coche? En este caso, el operador del vehículo fue inculpado de conducción temeraria.

Pero, ¿qué sucedería si el coche no tuviera ningún conductor y fuera totalmente autónomo? ¿Y qué pasaría si ese coche no reconociera a un peatón cruzando la calle porque el semáforo estaba en verde? A medida que la Inteligencia Artificial se implementa en más y más situaciones, la pregunta de la responsabilidad se hace cada vez más urgente.

Algunas jurisdicciones, como la UE, están avanzando en la legislación que regula la culpabilidad de la IA. La norma se esforzará por establecer distintas “obligaciones para proveedores y usuarios en función del nivel de riesgo derivado” de la IA.

A todos nos interesa ser lo más cuidadosos posible al utilizar la IA. El operador del coche autónomo podría haber prestado más atención a la carretera, por ejemplo. Las personas que comparten contenido en las redes sociales pueden actuar con más diligencia para asegurarse de que lo que comparten no es un deepfake u otra forma de contenido generado por IA.

4. ¿Cómo equilibramos las ventajas de la IA con sus problemas de seguridad/privacidad?

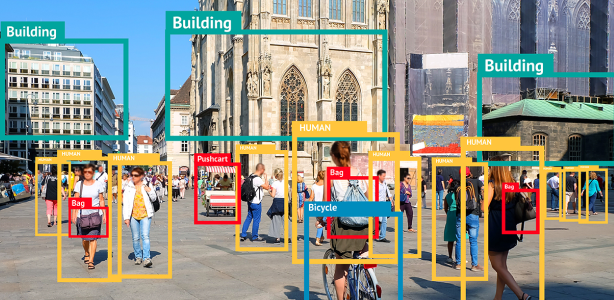

Puede que ésta sea la cuestión más acuciante de todas las relacionadas con el uso adecuado de la IA. Cualquier algoritmo necesita grandes cantidades de datos de entrenamiento para desarrollarse. En los casos en que el modelo vaya a evaluar a personas de la vida real para tomar medidas antifraude, por ejemplo, es probable que tenga que entrenarse con información del mundo real. ¿Cómo se aseguran las organizaciones de que los datos que utilizan no corren el riesgo de ser robados? ¿Cómo saben los individuos qué información comparten y con qué fines se utiliza?

Esta pregunta está compuesta por muchas interrogantes más pequeñas que se intentan abordar para llegar al fondo del asunto. El desafío más grande que enfrentan los individuos al respecto es saber si pueden depositar su confianza en aquellas organizaciones que afirman usar sus datos de forma segura y para el bienestar general.

5. Las personas deben tomar medidas para garantizar el uso adecuado de su información

Si te preocupa que tu información se esté utilizando para entrenar a la IA, o si piensas que tu información puede estar en peligro, hay una serie de pasos que puedes tomar para protegerte. Uno es elegir las cookies correctas cuando navegas por Internet. Debido a que la GDPA y la CCPA están en vigor, la mayoría de las empresas que hacen negocios en los EE.UU. o la UE deben advertir en su sitio web sobre la recopilación de información de navegación. Establecer tus preferencias es una buena forma de evitar que las empresas usen información cuando tú no quieres.

La segunda es aprovechar herramientas de terceros como McAfee+, que proporciona servicios como VPN, privacidad y protección de identidad y ofrece una completa plataforma de seguridad integral. Con la protección total contra el robo de identidad, tendrás una capa adicional de seguridad que funciona de forma complementaria a la elección de cookies y otros buenos hábitos de navegación que hayas desarrollado. No te limites a esperar que tus datos se utilicen adecuadamente: protégelos, cuanto antes.